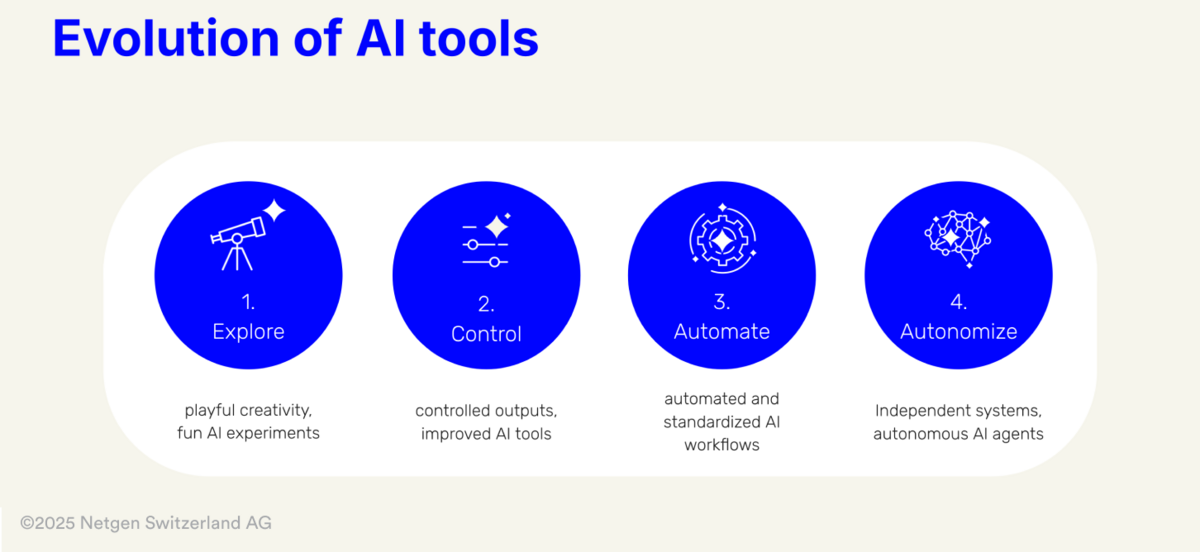

Generative KI-Werkzeuge haben sich zu einem dynamischen Feld entwickelt. Diese Entwicklung der KI-Tools kann in vier definierte Phasen unterteilt werden: «Exploring, Controlling, Automate, Autonomize». Jede der vier Phasen stellt eine bedeutende Veränderung in der Interaktion zwischen Kreativen und Technologie dar und ermöglicht immer präzisere und effizientere Ergebnisse.

Diese Klassifizierung der Entwicklung von Design-Tools, die ich erstmals in meinem vorherigen Blogbeitrag «AI & Creativity 4: Use Cases, Ideas, and Concepts at Netgen» vorgestellt habe, bietet einen Rahmen für das Verständnis der technologischen Entwicklung im kreativen Bereich.

In der «Explore»-Phase dominierten experimentelle Ansätze, die es ermöglichten, kreative Möglichkeiten spielerisch und mit offenen Ergebnissen zu entfalten – von «Katzen im Stil van Goghs» bis hin zu humorvollen Szenarien wie «Royals auf einer Party».

In der «Control»-Phase hingegen liegt der Fokus auf präzisen Anpassungen und gezielter Steuerung. Sie markiert einen bedeutenden Durchbruch, da Kreative modernste Tools und Schnittstellen nutzen können, um ihre Ergebnisse effizient zu kontrollieren und anzupassen und ihren Ideen eine spezifische Form und einen spezifischen Ausdruck zu verleihen.

Dieser Artikel konzentriert sich auf die «Control»-Phase und untersucht, wie sie die kreative Praxis revolutioniert. Wir untersuchen Technologien und Arbeitsabläufe in den Kategorien Bild, Video, Ton und 3D, die die Effizienz steigern und gleichzeitig die künstlerische Freiheit fördern.

|

Index |

1. Die Bedeutung der «Control»-Phase in kreativen Prozessen

Die «Control»-Phase schliesst die Lücke zwischen kreativer Freiheit und präziser Kontrolle. Kreative erhalten Zugang zu Tools, die:

- Präzise Ergebnisse kontrollieren: durch Parameter wie Stil, Struktur und Details.

- Konsistenz gewährleisten: insbesondere bei Projekten, die mehrere Elemente oder Wiederholungen erfordern.

- Zeit und Ressourcen sparen: durch Minimierung der manuellen Nachbearbeitung.

«Da KI zum Standard wird, ist die nahtlose Integration von Funktionen über UI und UX, für die Software-Anbieter von entscheidender Bedeutung, um sich von der Masse der Tools abzuheben.»

–

Neue Tools und ihre Rolle in der «Control»-Phase

Die heutige Generation von KI-Tools bietet intuitive Benutzeroberflächen und Arbeitsabläufe, die eine Steuerung nicht nur ermöglichen, sondern auch benutzerfreundlich machen. Tools wie MidJourney's Moodboards, ControlNet, Motion Brushes oder Krea.AI's Image Editor veranschaulichen diesen bemerkenswerten Wandel.

Genug der Theorie – lassen Sie uns konkrete Anwendungen dieser Tools in den Medienkategorien Bild, Video und Ton erkunden:

2. Image: Präzise Kontrolle im visuellen Design

Style Transfer

Einer der zentralen Aspekte der Bildbearbeitung in der «Control»-Phase sind die «Style Transfers». Dadurch können bestimmte Stile, Farbpaletten oder Texturen präzise auf neue Inhalte angewendet werden. Dies vereinfacht nicht nur die Umsetzung kreativer Visionen, sondern ermöglicht auch Neuinterpretationen und stilistische Erweiterungen bestehender Werke.

Ob für Branding, Konzeptkunst oder andere visuelle Medien – der Stiltransfer optimiert und personalisiert kreative Ergebnisse. Im Vergleich zu herkömmlichen Methoden überträgt es Stile schnell und präzise, was ihn besonders wertvoll für Grossprojekte macht. Werfen wir einen Blick auf einige der bekanntesten Tools.

Moodboards

Midjourney hat mit seinen Personalisierungsoptionen und Moodboards eine bahnbrechende Funktion eingeführt:

- So funktioniert es: Benutzer erstellen Moodboards, indem sie eine Auswahl von Bildern hochladen. Die KI generiert einen «style code», der verwendet werden kann, um Ergebnisse basierend auf den Stilen der hochgeladenen Bilder zu generieren.

- Anwendungen: Branding, Konzeptkunst, Modedesign, Erweiterung der Bildsprache.

- Vorteil: Konsistenz und Individualität durch visuelle Kontrolle.

Hier ein Beispiel von Rory Flynn:

Mixing Consoles

Mit Tools wie Realtime Gen von Leonardo.AI können Sie die Auswirkungen verschiedener Parameter mithilfe einfacher Schieberegler steuern und erhalten Live-Feedback zu Ihrem Ergebnis:

- So funktioniert es: Benutzer können via Schieberegler bestimmte Parameter anpassen, z. B. Farbtöne, Textur oder stilistische Intensität, sogar Mimik und Emotionen. Diese Anpassungen werden in Echtzeit auf die Ausgabe angewendet, sodass das Design direkt, schrittweise verfeinert werden kann.

- Anwendungen: Stil-, Hintergrund- oder Zeichenparameter anpassen, um Variationen Ihrer Idee zu erstellen

- Vorteil: direktes Feedback, einfache intuitive Handhabung

Ein beeindruckendes Beispiel, das von Billy Boman gepostet wurde:

Bildaufbau und Komposition

Mapping

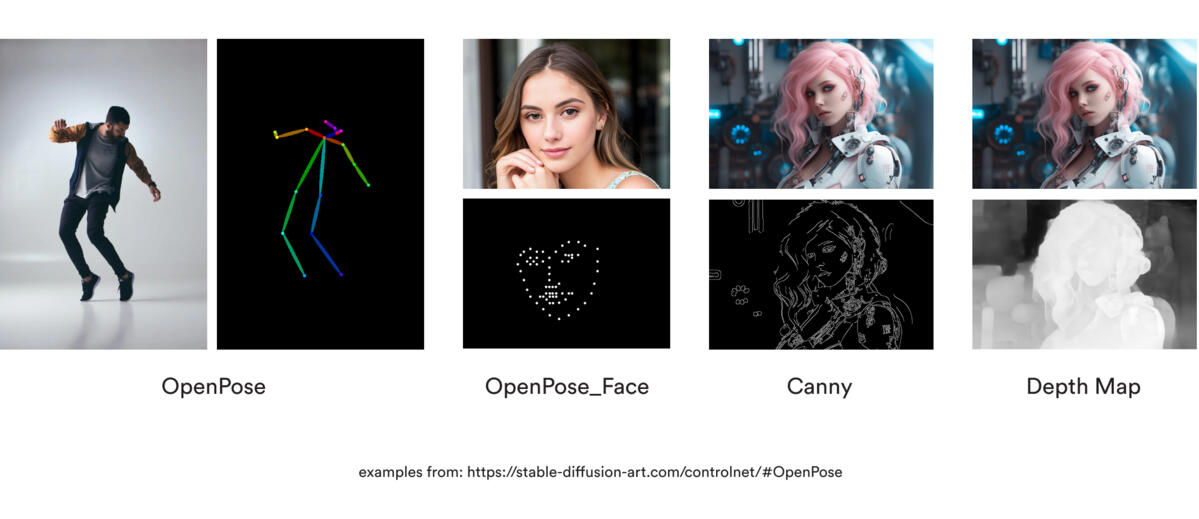

ControlNet revolutioniert die generative KI, indem es Benutzern ermöglicht, die Ergebnisse mithilfe von Steuerparametern wie «Depth Maps», «Edge Maps» oder Skizzen präzise zu steuern.

- So funktioniert es: ControlNet überlagert externe Eingabedaten wie menschliche Posen, Objektgrenzen oder «Depth Maps» (Tiefenkarten) mit Stable-Diffusion-Modellen, um hochpräzise Ergebnisse zu erzielen. So kann beispielsweise ein Architekt eine «Depth Map» verwenden, um konsistente strukturelle Entwürfe zu erstellen, oder ein Storyboard-Künstler kann «Edge Maps» verwenden, um Animationen zu verfeinern. Weitere Informationen finden Sie in diesem detaillierten Leitfaden zu ControlNet.

- Anwendungen: ControlNet wird häufig in der Architekturvisualisierung, im Charakterdesign und in der Videoproduktion eingesetzt und schliesst die Lücke zwischen kreativer Ideenfindung und praktischer Umsetzung.

- Vorteil: Es ermöglicht den Entwicklern, die volle Kontrolle über die künstlerischen Elemente zu behalten, und stellt sicher, dass die Ergebnisse genau den Projektanforderungen entsprechen, während manuelle Anpassungen minimiert werden.

«Real-Time» Zeichnungen

Krea.AI führt eine bahnbrechende Echtzeit-Zeichenfunktion ein, mit der Benutzer interaktiv visuelle Darstellungen erstellen und verfeinern können.

- So funktioniert es: Benutzer zeichnen auf einer digitalen Leinwand, während KI die Skizzen in Echtzeit verfeinert. Tools wie anpassbare Pinselgrößen, Radierer und Rückgängig/Wiederholen sorgen für reibungslose Arbeitsabläufe.

- Anwendungen: Diese Funktion ist ideal für die Erstellung von Konzepten und Storyboards und vereinfacht die Umsetzung von Ideen in ausgefeilte Ergebnisse mit Anpassungen in Echtzeit.

- Vorteil: Dynamische Arbeitsabläufe werden durch die nahtlose Integration von KI-gesteuerten Verfeinerungen unterstützt, was die Kreativität fördert und gleichzeitig Zeit spart.

Weitere Informationen zu dieser Funktion finden Sie im Krea.AI's Real-Time Drawing Guide.

Image Editors

Krea.AI’s Image Editor ermöglicht beispielsweise die Bearbeitung und Skalierung in «Real-Time»:

- Funktionsweise: Kombiniert Textaufforderungen mit interaktiven Tools auf einer Leinwand.

- Anwendungen: Mustergestaltung, Produktvisualisierung, UI/UX-Prototyping.

- Vorteil: Flexible «Real-Time»-Anpassungen bestimmter Bereiche.

Einen Ansatz, der auf einer Schnittstelle basiert und beispielsweise «Mixing Consoles» mit der «Canvas» kombiniert, finden Sie in der Vizcom's «Mix-Funktion».

3. Video: Kontrollierte Kreativität in Bewegung

Generative Videos sind ein dynamisches Entwicklungsfeld und bietet Kreativen in der «Control»-Phase völlig neue Möglichkeiten. Von der Animation bis zur Bearbeitung komplexer Sequenzen oder deren Erweiterung bieten moderne Tools präzise Steuerungsoptionen, die sowohl die Effizienz als auch die künstlerische Qualität steigern.

Die Videogenerierung hat einen unglaublichen Sprung nach vorne gemacht, wobei alle grossen Anbieter ihre Entwicklung im letzten Quartal 2024 beschleunigt haben – Hailulo AI, LumaLabs, Minimax, Runway oder Kling AI.

Erinnern Sie sich noch daran, wie «Will Smith» 2023 Spaghetti ass? Sehen Sie sich das jetzt an: 2025.

OpenAI's lang erwartetes SORA wurde endlich veröffentlicht, nur um sofort von Googles Veo 2 entthront zu werden, das mit seinem „«hysischen Verständnis» in Animationen triumphierte – sehen Sie sich beispielsweise an, wie es die Fleischscheiben im Vergleich (von Andreas Horn) animiert, oder die Lichter und Schatten (von Lazlo Gaal) berücksichtigt – beeindruckend, oder?

Motion Brushes

Motion Brush ist ein intuitives Tool zur Erstellung von Animationen, das Benutzern durch «Anzeichnen» der gewünschten Bewegungs-Pfade auf einer interaktiven Leinwand präzise Kontrolle über die Bewegungen von Objekten gibt. Es ist besonders vielseitig in Bereichen wie Animation, visuelle Effekte und Erklärvideos.

Ein bemerkenswertes Beispiel ist der Motion Brush von Kling.AI, der eine detaillierte Bewegungssteuerung bietet. Erfahren Sie mehr in diesem Artikel.

Ein weiteres Beispiel ist der in Runway verfügbare Motion-Brush. Weitere Informationen finden Sie in der Runway Gen-2 Motion Brush Academy.

Video-to-Video

Style Transfers für Videos ermöglichten die Analyse vorhandener Videos und die Anwendung ihrer Stile – wie Farbschemata, Texturen oder visuelle Effekte – auf neue Sequenzen. Diese Technologie kann in der Film-Postproduktion und bei visuellen Effekten eingesetzt werden, um ein einheitliches Styling in Serienproduktionen zu gewährleisten. Ein entscheidender Vorteil ist die Konsistenz über mehrere Clips hinweg, wobei gleichzeitig Raum für kreative Neuinterpretationen bleibt.

Ein grosser Vorteil ist auch, wenn «simple» Eingabevideos mithilfe von Stilreferenzen (Text-, Bild- oder Videoaufforderungen) oder Prompts in den gewünschten «hochwertigen» Look umgewandelt werden können, wie dieses Beispiel von MoveAI zeigt:

Keyframes

Keyframes ermöglichen eine präzise Steuerung von Animationen, indem Start-, Mittel- und Endbilder als Bilder hochgeladen werden können, wodurch präzise Bewegungen und stilistische Übergänge zwischen Sequenzen definiert werden. Hier ist ein Beispiel von Rory Flynn, das mit Runway erstellt wurde:

Ein Paradebeispiel ist das Luma Keyframes Tool. Weitere Informationen finden Sie in der Luma Keyframes-Dokumentation.

SORA von OpenAI macht mit seiner «Storyboard»-Funktion einen Sprung nach vorne. Es bietet eine erweiterte, intuitive Kontrolle über KI-generierte Sequenzen und ermöglicht es Benutzern, die Erstellung von Inhalten präzise und mit erzählerischer Kohärenz zu skizzieren und zu steuern.

Im Dezember 2024 stellte Runway einen innovativen Ansatz zur Bearbeitung von Bild- und Videogenerationen durch eine grafisch strukturierte Kartierung des «latent space» vor. Diese Methode ermöglicht eine «non-linear exploration» kreativer Ergebnisse und bietet eine beispiellose Flexibilität und Präzision bei der Navigation und Verfeinerung von KI-generierten Inhalten. Mehr unter Runway's Creativity as Search.

4. Sound: Steuerung der akustischen Ausgabe

Die Möglichkeit, die akustische Ausgabe zu steuern, ist ein entscheidender Faktor für die Produktion hochwertiger Audio-Inhalte. KI-gestützte Tools ermöglichen eine schnelle und präzise Optimierung von Soundtracks, von der Rauschunterdrückung bis hin zur Feinabstimmung von Intonation und Lautstärke (oft via Eingaben in natürlicher Sprache).

Eine bemerkenswerte Entwicklung auf diesem Gebiet ist Adobe's Project Super Sonic, das auf drei innovativen Funktionen basiert:

- Text-to-Audio-Generierung: Benutzer können realistische Soundeffekte durch Textaufforderungen erstellen, z. B. «eine Tür knarrt auf».

- Objekterkennungsbasierte Klangerzeugung: Die KI analysiert Videobilder, identifiziert Objekte und erzeugt entsprechende Soundeffekte, z. B. das Geräusch eines Toasters, der das Aufspringen von Toast erzeugt.

- Sprachgesteuerte Klangerzeugung: Benutzer können gewünschte Klänge nachahmen und die KI wandelt diese in Audioeffekte in professioneller Qualität um.

Diese Funktionen ermöglichen eine präzisere und schnellere Erstellung von Audiospuren und eröffnen neue kreative Möglichkeiten.

KI-gestützte Audio-Design-Tools

zur Verbesserung und Anpassung von Audiotracks:

- Funktionsweise: Bearbeitung von Intonation, Lautstärke und Rauschunterdrückung mithilfe von KI.

- Anwendungen: Podcasts, Voice-Over, Filmdialoge.

- Vorteil: Zeitersparnis durch automatisierte Optimierung.

Adobe Podcast ist ein leistungsstarkes Tool zur Audio-Optimierung. Mit KI-gesteuerten Funktionen wie Rauschunterdrückung und Stimmverbesserung vereinfacht es die Audiobearbeitung sowohl für Anfänger als auch für Profis. Es ist ideal für Podcaster und Audio-Editoren und produziert effizient und zeitsparend hochwertige Ergebnisse.

ElevenLabs: Fortgeschrittene Soundeffekte

ElevenLabs hat die Erstellung von Audioinhalten mit seinem innovativen Tool zur Erzeugung von Soundeffekten revolutioniert. Diese Plattform ermöglicht es Benutzern, Beschreibungen einzugeben oder aus einer Bibliothek von Audio-Ansagen auszuwählen, um präzise und hochwertige Soundeffekte zu erzeugen. Dieses Tool vereinfacht den Sounddesign-Prozess, indem es komplexe Audio-Aufgaben automatisiert, Zeit spart und gleichzeitig eine aussergewöhnliche Qualität gewährleistet. Weitere Informationen finden Sie unter ElevenLabs Sound Effects.

Suno: «Audio-Inputs» – Eigene Songs aus jedem beliebigen Sound

Suno stellt eine innovative Methode vor, mit der sich Musik aus jedem beliebigen Sound erstellen lässt. Mit diesem Tool können Benutzer alltägliche Klänge mithilfe fortschrittlicher KI-Algorithmen in Musikkompositionen umwandeln.

- So funktioniert es: Benutzer stellen einen Audio-Input bereit, z. B. einen Sprachausschnitt oder einen Umgebungsgeräusch, den die KI dann verarbeitet und in ein musikalisches Arrangement umwandelt.

- Anwendungen: Ideal für Musikproduktion, Sounddesign und experimentelle Audioprojekte.

- Vorteil: Sunos Tool schliesst die Lücke zwischen Audio-«Rohmaterial» und kreativem Output und ermöglicht es Benutzern, mühelos einzigartige Musik zu erzeugen. Weitere Informationen finden Sie unter „Suno Audio Inputs“.

5. Hinzufügen von Dimensionen – 3D

KI revolutioniert die 3D-Elementgenerierung, bietet eine beispiellose Präzision und fördert innovative Designs. Durch den Einsatz KI-gesteuerter Tools können Entwickler Konzepte effizient verfeinern oder komplexe Modelle mit bemerkenswerter Genauigkeit (re)konstruieren. Diese transformative Integration optimiert nicht nur Arbeitsabläufe, sondern eröffnet auch neue kreative Horizonte und ermöglicht es Designern, Grenzen zu überschreiten und Ergebnisse zu erzielen, die bisher als unerreichbar galten. Die Synergie zwischen KI und 3D-Workflows setzt neue Massstäbe für Effizienz und Kreativität in diesem Bereich.

Generative 3D-Inhalte mit Vizcom

Vizcom hat kürzlich ein innovatives Tool zur Erstellung von 3D-Inhalten vorgestellt, das den kreativen Prozess möglicherweise verändern wird. Das Tool nutzt KI, um aus einfachen Skizzen oder Konzepten realistische 3D-Modelle zu erstellen, und integriert generative KI nahtlos in den Arbeitsablauf:

- So funktioniert es: Benutzer können 2D-Skizzen oder Entwürfe hochladen und die KI generiert automatisch detaillierte 3D-Modelle. Das Tool bietet ausserdem erweiterte Optionen wie perspektivische Anpassung, Materialsimulation und Texturverwaltung, um das Ergebnis zu verfeinern. Diese Funktionen stellen sicher, dass die Modelle sowohl optisch ansprechend als auch technisch funktional sind.

- Anwendungen: Produktdesign, Architektur, visuelle Effekte und Prototypen-Entwicklung.

- Vorteil: Beschleunigt den Designprozess und bietet eine intuitive Möglichkeit, Ideen in umsetzbare Modelle zu verwandeln. Weitere Informationen finden sich unter «Vizcom's 2D to 3D Feature».

Text-to-3D mit Stable Point-Efficient Architecture

Die Generierung von 3D-Objekten aus Textbeschreibungen hat mit der innovativen Stable Point-Efficient Architecture von Stability AI neue Höhen erreicht.

- So funktioniert es: Diese Technologie verwendet KI, um Textbeschreibungen in genaue 3D-Modelle zu übertragen. Sie optimiert die Ressourcennutzung bei gleichzeitiger Beibehaltung der Modellgenauigkeit und -treue und eignet sich daher für verschiedene Anwendungen.

- Anwendungen: Ihre Vielseitigkeit zeigt sich in AR/VR-Erlebnissen, Architekturvisualisierungen und der Spieleentwicklung, wo hochwertige 3D-Inhalte unerlässlich sind.

- Vorteil: Durch die Reduzierung des Rechenaufwands ermöglicht dieser Ansatz eine schnellere Prototypen-Erstellung, ohne dass dabei Details oder Genauigkeit beeinträchtigt werden. Mehr hierzu in der offiziellen Ankündigung von Stability AI.

Trellis: 3D-Asset-Erstellung im Wandel

Microsofts Trellis stellt einen bahnbrechenden Ansatz zur Erstellung von 3D-Assets vor, bei dem KI zur Rationalisierung und Optimierung des gesamten Workflows eingesetzt wird.

- So funktioniert es: Trellis ermöglicht es Benutzern, Skizzen oder Rohdaten einzugeben, die von der KI zu hochwertigen 3D-Modellen verfeinert werden. Die Algorithmen gewährleisten strukturelle Integrität und Designpräzision, wodurch sich Trellis ideal für komplexe Modellierungsaufgaben eignet.

- Anwendungen: Trellis wird häufig in der Spieleentwicklung, in Virtual-Reality-Umgebungen und im Industriedesign eingesetzt und beschleunigt die Erstellung von Assets bei gleichbleibend hoher Qualität.

- Vorteil: Durch die Reduzierung des Zeit- und Arbeitsaufwands für manuelle Anpassungen können sich die Entwickler auf die innovativen und kreativen Aspekte ihrer Projekte konzentrieren. Weitere Informationen unter Microsoft Trellis.

Hier ein Beispiel von Will Eastcott:

Krea.AI: Bilder in 3D-Objekte umwandeln

Ein letztes Beispiel, das zeigt, wie schnell die Grenzen zwischen 2D und 3D durch KI verwischt werden, ist die Krea.AI-Funktion, die Bilder in Echtzeit in 3D-Objekte umwandelt und integriert:

6. Fazit: Die «Control»-Phase als neuer Standard für kreative Arbeit

Die «Control»-Phase stellt einen Wendepunkt in der Entwicklung der generativen KI dar. Tools wie MidJourney, ControlNet, Motion Brush und Krea.AI bieten ein neues Mass an kreativer Kontrolle, steigern die Produktivität und erweitern die künstlerische Freiheit.

Für Kreative bedeutet dies, dass sie in Zukunft über präzise Werkzeuge verfügen, um ihre Visionen zum Leben zu erwecken – sei es in Bild, Video, Ton oder 3D.

Letztendlich sind diese Werkzeuge jedoch nur das: Werkzeuge. Um sich von der Masse abzuheben, kommt es immer mehr darauf an, die richtige Idee zu haben, um diesen Technologien einen einzigartigen Ausdruck zu verleihen.

«Diese Entwicklungen markieren nicht das Ende, sondern den Beginn einer neuen Ära der kreativen Arbeit, in der qualitativ hochwertige Ideen den Unterschied machen werden.»

–

Welche Erfahrungen haben Sie mit diesen Tools gemacht? Wir freuen uns auf Ihre Kommentare und Vorschläge!

Epilog

Die nächsten Phasen, «Automate» und «Autonomize», versprechen noch spannendere Entwicklungen. In der «Automate»-Phase wird sich die KI auf die Automatisierung sich wiederholender Aufgaben konzentrieren, wodurch kreative Prozesse noch effizienter werden können. «Autonomize» zielt darauf ab, die KI in die Lage zu versetzen, völlig unabhängige kreative Entscheidungen zu treffen.

Beide Phasen werden in den kommenden Blog-Beiträgen näher beleuchtet werden. Sie werden im Jahr 2025 für Kreative und Unternehmen gleichermassen von entscheidender Bedeutung sein, da sie die Effizienz steigern und innovatives Potenzial freisetzen können – Bleiben Sie dran, um zu erfahren, wie sich die Zukunft der kreativen Arbeit gestalten wird!